Google Voice Search

Google je jedan od pionira u istraživanju umjetne inteligencije i mnoštvo njihovih projekata pretvorilo se u glave. AlphaZero od Googleovih Duboki um tim bio je proboj u istraživanju umjetne inteligencije, zahvaljujući sposobnosti programa da sam nauči komplicirane igre (bez ljudskog treninga i intervencije). Google je također izvrsno radio u Programi za obradu prirodnog jezika (NLP), što je jedan od razloga učinkovitosti Google asistenta u razumijevanju i obradi ljudskog govora.

Google je nedavno najavio izlazak tri nova KORISTITE višejezične module i pružaju višejezične modele za dohvaćanje semantički sličnog teksta.

Prva dva modula pružaju višejezične modele za dohvaćanje semantički sličnog teksta, jedan optimiziran za izvedbu dohvaćanja, a drugi za brzinu i manje upotrebe memorije. Treći model je specijaliziran za pronalaženje pitanja-odgovora na šesnaest jezika (USE-QA) i predstavlja potpuno novu primjenu USE. Sva tri višejezična modula treniraju se pomoću a multi-task dual-encoder framework , slično izvornom USE modelu za engleski jezik, koristeći tehnike koje smo razvili za poboljšanje dual-encoder s aditivnom marginom softmax pristup . Oni su dizajnirani ne samo za održavanje dobrih performansi učenja prijenosa, već i za dobro obavljanje n semantičkih zadataka dohvaćanja.

Obrada jezika u sustavima prešla je dug put, od raščlanjivanja osnovnog stabla sintakse do velikih vektorskih modela. Razumijevanje konteksta u tekstu jedan je od najvećih problema na polju NLP-a, a univerzalni koder rečenice to rješava pretvaranjem teksta u visokodimenzionalne vektore, što olakšava rangiranje i označavanje teksta.

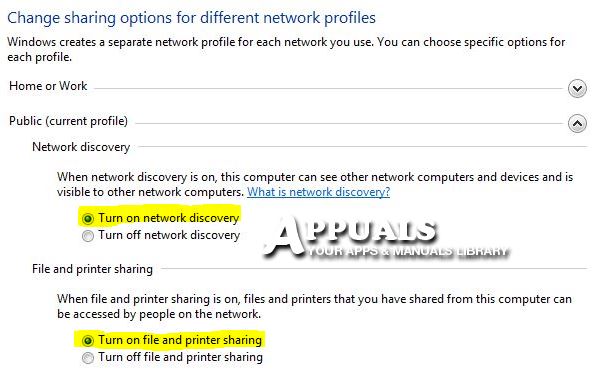

Izvor strukture označavanja UTE - Google blog

Prema Googleu, „ Sva tri nova modula izgrađena su na semantičkoj arhitekturi pretraživanja, koja obično dijeli kodiranje pitanja i odgovora u zasebne neuronske mreže, što omogućuje pretraživanje među milijardama potencijalnih odgovora u milisekundama. ”Drugim riječima, ovo pomaže u boljem indeksiranju podataka.

' Sva tri višejezična modula treniraju se pomoću a multi-task dual-encoder framework , slično izvornom USE modelu za engleski jezik, koristeći tehnike koje smo razvili za poboljšanje dual-encoder s aditivnom marginom softmax pristup . Oni su dizajnirani ne samo za održavanje dobrih performansi učenja prijenosa, već i za dobro obavljanje n semantičkih zadataka dohvaćanja . ' Softmax funkcija često se koristi za uštedu računske snage potenciranjem vektora, a zatim dijeljenjem svakog elementa zbrojem eksponencijala.

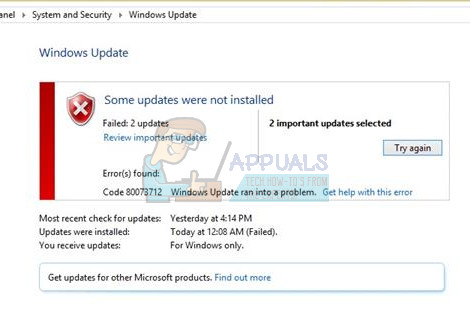

Semantička dohvatna arhitektura

„Sva tri nova modula izgrađena su na semantičkim arhitekturama pretraživanja, koje obično dijele kodiranje pitanja i odgovora u zasebne neuronske mreže, što omogućuje pretraživanje među milijardama potencijalnih odgovora u milisekundama. Ključ upotrebe dvostrukih kodera za učinkovito semantičko pronalaženje je prethodno kodiranje svih odgovora kandidata na očekivane ulazne upite i njihovo spremanje u vektorsku bazu podataka koja je optimizirana za rješavanje problem najbližeg susjeda , što omogućuje brzu i dobru pretragu velikog broja kandidata preciznost i opoziv . '

Ove module možete preuzeti s TensorFlow Hub-a. Za daljnje čitanje pogledajte GoogleAI's full blogpost .

Oznake google